Paolo Attivissimo's Blog, page 7

May 12, 2024

Sono a Bratislava per Starmus: si comincia con il concerto di Jean-Michel Jarre e Brian May

Sono tornato a postare su Twitter/X per raccontare il festival di scienza e musica Starmus, che inizia stasera a Bratislava con un concerto di Jean-Michel Jarre e Brian May.

Buongiorno da Bratislava, sono qui per raccontarvi @StarmusFestival! Si, ho fatto la spunta blu su X apposta, vediamo che succede pic.twitter.com/scrQusBxWY

— Paolo Attivissimo @ildisinformatico@mastodon.uno (@disinformatico) May 12, 2024

Posterò anche su Instagram e Mastodon, e mi sono iscritto alla spunta blu di Twitter turandomi il naso, ma ho letto i vostri pareri molto saggi sull’idea di vendere il mio account Twitter e alla fine ho deciso di tenerlo e di riprendere a usarlo almeno per diffondere conoscenza e segnalare diffusamente eventi interessanti.

Non lo userò per conversare, ma se devo scegliere come far sapere che si parla di scienza con un bouquet incredibile di premi Nobel, astronauti ed esperti ai massimi livelli, mi rassegno al fatto che 420.000 follower su Twitter hanno una portata ben superiore a 5300 su Instagram. E quindi sì, sto pagando otto dollari al mese a Elon Musk. Non odiatemi.

2024/05/13 00:30La Dama del Maniero e io siamo appena rientrati dal concerto. Notevolissimo, costruito benissimo, audio perfetto e concezione visionaria, con un riferimento importante a Edward Snowden. Il video è disponibile qui sotto e la lista dei brani dovrebbe essere questa:

Noi eravamo proprio dietro la telecamera montata su un binario a terra, che scorreva parallela al palco.

Scritto da Paolo Attivissimo per il blog Il Disinformatico. Ripubblicabile liberamente se viene inclusa questa dicitura (dettagli). Sono ben accette le donazioni Paypal.Sono a Bratislava per Starmus

Sono tornato a postare su Twitter/X per raccontare il festival di scienza e musica Starmus, che inizia stasera a Bratislava con un concerto di Jean Michel Jarre e Brian May.

Buongiorno da Bratislava, sono qui per raccontarvi @StarmusFestival! Si, ho fatto la spunta blu su X apposta, vediamo che succede pic.twitter.com/scrQusBxWY

— Paolo Attivissimo @ildisinformatico@mastodon.uno (@disinformatico) May 12, 2024

Posterò anche su Instagram e Mastodon, e mi sono iscritto alla spunta blu di Twitter turandomi il naso, ma ho letto i vostri pareri molto saggi sull’idea di vendere il mio account Twitter e alla fine ho deciso di tenerlo e di riprendere a usarlo almeno per diffondere conoscenza e segnalare diffusamente eventi interessanti.

Non lo userò per conversare, ma se devo scegliere come far sapere che si parla di scienza con un bouquet incredibile di premi Nobel, astronauti ed esperti ai massimi livelli, mi rassegno al fatto che 420.000 follower su Twitter hanno una portata ben superiore a 5300 su Instagram. E quindi sì, sto pagando otto dollari al mese a Elon Musk. Non odiatemi.

2024/05/13 00:30La Dama del Maniero e io siamo appena rientrati dal concerto. Notevolissimo, costruito benissimo, audio perfetto e concezione visionaria. Il video è disponibile qui sotto:

Noi eravamo proprio dietro la telecamera montata su un binario a terra, che scorreva parallela al palco.

Scritto da Paolo Attivissimo per il blog Il Disinformatico. Ripubblicabile liberamente se viene inclusa questa dicitura (dettagli). Sono ben accette le donazioni Paypal.May 9, 2024

Podcast RSI - Svizzera, rapporto federale: raddoppiano gli incidenti informatici. Come rimediare (prima parte)

ALLERTA SPOILER: Questo è il testo di accompagnamento al podcast Il Disinformatico della Radiotelevisione Svizzera che uscirà questo venerdì (domani) presso www.rsi.ch/ildisinformatico.

Le puntate del Disinformatico sono ascoltabili anche tramite iTunes, Google Podcasts, Spotify e feed RSS.

---

[CLIP: Descrizione di un hackeraggio da “Mr. Robot”]

[CLIP: Descrizione di un hackeraggio da “Mr. Robot”]I toni drammatici di un telefilm comeMr. Robot, dal quale è tratto questo spezzone, possonosembrare fantasiosi ed esagerati, ma non sono poi così tanto lontanidalla realtà degli attacchi informatici.

Le tecniche descritte da questa seriesono infatti realistiche, anche se c’è qualche licenza narrativaper esempio sui tempi di esecuzione, e sappiamo che sono realisticheperché i resoconti reali degli addetti ai lavori raccontano di unmondo sommerso di attacchi veri, sferrati contro aziende einfrastrutture, da cui solo ogni tanto affiora nella cronaca qualcheepisodio particolarmente sensazionale.

Fra questi resoconti c’è quellosemestrale dell’Ufficio federale della cibersicurezza svizzero oUFCS, di cui è appena stata pubblicata una versioneaggiornata scaricabile, riferita al secondo semestre del 2023,che contiene dati, statistiche, esempi di casi concreti e tantissimerisorse utili da conoscere per evitare di diventare uno di quei datie di entrare a far parte di quelle statistiche.

Ma èscritto in linguaggio piuttosto tecnico, e a pochi verrà in mente dileggersi quaranta paginefitte di un testo intitolato,in modo molto pragmatico ma poco accattivante, Rapportosemestrale 2023/II (luglio-dicembre) - Sicurezza delle informazioni -La situazione in Svizzera e a livello internazionale.L’ho fatto io per voi, e così posso raccontarvi le cose piùimportanti da sapere per essere pronti alle nuove sfide di sicurezzainformatica. E se avete pensato che sicuramente ci sarà di mezzol’intelligenza artificiale, non avete torto.

Benvenutiallapuntata del 10maggio 2024 delDisinformatico, ilpodcast della Radiotelevisione Svizzera dedicato alle notiziee alle storie stranedell’informatica. Io sono Paolo Attivissimo.

[SIGLA di apertura]

Tecniche classiche in aumento, ma cala ilransomwarePer capire correttamente questo rapporto è necessario partire dauna premessa che ci riguarda tutti: i suoi dati si basano sullesegnalazioni degli attacchi, fatte alle autorità, ossiaall’Ufficio federale della cibersicurezza, da chi li ha subiti. Inumeri del rapporto, insomma, non rappresentano tutti i“ciberincidenti”, per usare la terminologia del documento,ma soltanto quelli segnalati.

Questo vuol dire che le segnalazioni sono importantissime per gliaddetti ai lavoro, contrariamente a quello che molti pensano, cioèche sia inutile informare le forze dell’ordine di un attaccosubìto, perché tanto le speranze di ottenere la punizione deicolpevoli sono minime. Sì, è vero che i criminali informaticirisiedono quasi sempre all’estero, in paesi nei quali sanno che nonverranno perseguiti, e quindi è improbabile avere giustizia oriavere i soldi o i dati sottratti con la frode informatica, masegnalare gli attacchi serve per consentire agli esperti di saperequali sono le tecniche più frequenti e quindi per concentrare i lorosforzi dove c’è maggiore bisogno, per “poter avvisarela popolazione e le imprese in caso di un’escalation dellaminaccia”, come dice appunto il rapporto, e a volte serve ancheper scoprire tecniche inedite.

È importante anche distinguere le segnalazionidalle denunce: lesegnalazioni sono molto più semplici da fare. Il rapportoconsiglia di farle online, presso l’appositapagina dell’Ufficio Federale della Cibersicurezza oppure presso il sitoAntiphishing.ch.Trovate i nomi e i link a tutte queste fonti pressoDisinformatico.info.

Detto questo, i numeri delle segnalazioni sono impressionanti: nelsecondo semestre del 2023 ne sono state inviate oltre 30.000, quasiil doppio rispetto allo stesso periodo del 2022. L’aumento, dice ilrapporto, è causato soprattutto dalle truffe, sotto forma di“offerte di lavoro fraudolente” e“chiamate fasulle a nome della polizia”.

Le offerte di lavoro fasulle sono state diffuse soprattuttotramite WhatsApp e hanno seguito uno schema piuttosto complicato che però illustra bene il livello di sofisticazione dei criminali. Chirispondeva a queste offerte riceveva infatti un elenco di mandati,per esempio redigere recensioni di prodotti, in cambio di un compensoversato su una piattaforma online gestita dai truffatori. Ma

“il numero di mandati disponibili” dice il rapporto “si azzerava rapidamente.Per accelerare l’attività e non dover aspettare, la piattaformadava la possibilità di generare a pagamento nuovi mandati. Per pochidollari si potevano così acquistare 50 nuovi mandati di recensione”spiega sempre il rapporto,aggiungendo che “Il guadagno promesso, che a sua voltaavrebbe dovuto essere accreditato sulla piattaforma, superava dimolto i costi, per cui la vittima pensava che valesse la penautilizzare quel modello. La brutta sorpresa arrivava quando si volevaincassare il guadagno accumulato. Il gestore della piattaformarichiedeva delle tasse per il versamento del guadagno finché lavittima si accorgeva che si trattava di una truffa.”

Le prese di contatto fasulle a nome della polizia, invece, erano avolte sotto forma di mail nelle quali si comunicava alla vittima cheera “ritenuta colpevole di un grave reato (in genere legato allapornografia minorile)” e che l’unico modo per evitareun’azione penale era versare una somma di denaro. Ma i criminalihanno anche effettuato raffiche di telefonate automatiche, nellequali una voce sintetica diceva di rappresentare un’autorità dipolizia e informava la vittima che per esempio i dati del suo contocorrente privato erano emersi in relazione a un dato reato e che peravere ulteriori informazioni doveva premere il tasto 1. Se la vittimalo faceva, la chiamata veniva inoltrata a un sedicente “operatore”che le chiedeva di scaricare un software di accesso remoto, che poipermetteva al criminale di insinuarsi nel computer o nel telefonocellulare per accedere alle credenziali di e-banking della vittima eusarle per inviare soldi dal conto della vittima a quello deitruffatori.

La classifica delle tecniche criminali più frequenti proseguecitando la cosiddetta “truffa del CEO”, cioè quella incui gli aggressori fingono di essere un membro importante diun’azienda e contattano uno dei dipendenti di quell’azienda perconvincerlo a inviare urgentemente del denaro a un conto bancariocontrollato dai truffatori, dicendo che si tratta di un pagamentonecessario per concludere un grosso accordo commerciale.

Si colloca in alto in classifica anche la tecnica in cui icriminali riescono a manipolare le fatture ricevute da un’azienda,per esempio alterando le loro coordinate di pagamento in modo dadirottare i soldi su un conto ancora una volta gestito daitruffatori.

Tutte queste forme di attacco sono in aumento, mentre sono indiminuzione gli attacchi di ransomware ai danni delle imprese,ossia quelli nei quali i criminali chiedono denaro per sbloccare icomputer aziendali di cui hanno preso il controllo oppure per nondisseminare i dati aziendali di cui si sono impadroniti.

Ma non sono mancati i tentativi di inganno basatisull’intelligenza artificiale.

Se ti hanno filmato nudo, dì che è un deepfake:IA nel crimine onlineIl rapporto dell’Ufficio federale di cibersicurezza (o UFCS)nota che nel 2023 i criminali hanno iniziato a usare l’intelligenzaartificiale nei loro attacchi. Per ora, dice il rapporto, non sitratta ancora di un uso sistematico ma solo di “tentativi concui i truffatori cercano di sondare cosa sia possibile o redditizio”.

In alcuni di questi tentativi segnalati, l’intelligenzaartificiale è stata usata “per creare foto o videocompromettenti allo scopo di ricattare la vittima. Basta che icriminali siano in possesso di filmati o fotografie del tuttoinnocenti registrate o scattate personalmente dalla vittima inprecedenza o magari accessibili a tutti su Internet. Da questi videoinnocui l’IA crea filmati pornografici o immagini di nudo”,ossia dei deepfake.L’UFCS “ritiene che questa forma di estorsione cresceràvertiginosamente negli anni a venire”,ma nota anche che l’esistenzadei deepfake èampiamente conosciuta dal grande pubblico equindi questa forma di ricatto potrebbe risultare inefficace perchéanche chi è stato realmenteripreso dai criminali in video compromettenti potrebbedire tranquillamente che si tratta di una ripresa fabbricata con l’intelligenzaartificiale.

I videofalsi generati con l’intelligenza artificiale sono stati usati daicriminali anche in un’altra forma, facendo dire in video a personefamose, come politici o grandi imprenditori, raccomandazionidi investimenti in criptovalute che erano in realtà fraudolenti.

Un altro esempio interessante diuso criminale dell’intelligenza artificiale viene segnalato dalrapporto dell’UFCS notando che varie imprese hanno segnalato diaver ricevuto “telefonate da loro presunti dipendentiche, con voce perfettamente simulata, si sarebbero informati suquestioni aziendali interne o avrebbero disposto l’esecuzione dipagamenti. I dipendenti in questione, tuttavia, erano completamenteignari di queste telefonate, che con tutta probabilità vengonogenerate tramite deepfake”,cioè con voci sintetichegenerate usando campioni di quelle reali.

Il rapporto cita anche un casomolto particolare nel quale si sospetta l’uso dell’intelligenzaartificiale: sono statesegnalate mail truffaldine, in apparenza provenienti da banche,scritte in svizzero tedesco, forsecon lo scopo di sembrarepiù realistiche e familiari, perché in effetti è facile pensareche sia improbabile che un criminale informatico che sta in chissàquale paese lontano sappia scrivere in una lingua così locale.Ma l’UFCS nota che nelmondo degli affari svizzero “si utilizza di prassi iltedesco standard” eche “[u]na presunta e-mail ufficiale provenienteda una banca e scritta in dialetto tenderebbe a insospettire lavittima piuttosto che convincerla a cliccare sul relativo link”.I criminali, in questo caso,hanno insomma preso un granchio.

Tuttavia c’è un altro settoredel crimine informatico in cui ha molto senso usare il dialetto: “letruffe legate ai piccoli annunci […]. Questo stratagemma infondefiducia nella vittima, dando l’impressione che acquirente evenditore provengano dalla medesima regione (linguistica)”.Sono già stati osservati i primi casi di annunci online fraudolentiscritti in buon svizzero tedesco, presumibilmenteusando software di traduzione basati sull’intelligenzaartificiale, per cui l’usodi questa forma di comunicazione non deve far abbassare la guardia, esapere questo fatto è il primo passo verso la prevenzione degliattacchi.

Torna il “voice phishing”Il rapporto dell’Ufficio federale di cibersicurezza si soffermapoi sull’impennata di segnalazioni di una tecnica di attaccosolitamente rara: il voice phishing,ossia l’ottenimento delle credenziali di sicurezza di una vittimaattraverso una telefonata fatta a voce, intempo reale, dai criminali.

Verso la fine dell’anno scorsosono stati segnalati molti casi di chiamate “da parte disedicenti impiegati di banca, che facevano credere di voler bloccareun pagamento fraudolento. In alcuni casi il numero di telefonovisualizzato corrispondeva persino a quello ufficiale della banca: sitratta in realtà di un numero che, attraverso la tecnica dello«spoofing», viene falsificato dai truffatori per farlo sembrarecredibile.” Conviene insommasapere che il numero di telefono del chiamante che vedete sulloschermo del vostro telefono non è affatto una garanzia diautenticità, come invece pensano in molti.

Ma l’astuzia dei criminali nonsi limita alla falsificazione del numero del chiamante. In alcunicasi, segnala il rapporto dell’UFCS,il finto impiegato di banca “consigliava di telefonareimmediatamente alla divisione antifrode della Polizia cantonale ecomunicava altresì il numero da chiamare”, dice il rapporto. Unacortesia spiazzante, che di certo non fa pensare che l’interlocutoresia un criminale, ma c’è l’inghippo: il numero che veniva fornito non era quello della divisione antifrode ma era anch’esso gestitodai malviventi.

L’altro ingrediente spiazzanteusato dai truffatori è l’apparente conoscenza della banca usatadalla vittima. È capitato anche a me di ricevere una di questetelefonate, nella quale la truffatrice (era una voce femminile)diceva che c’era un problema sul mio conto bancario e citavaproprio la banca presso la quale ho un conto. Come fanno i criminaliad avere queste informazioni?

In realtà non le hanno, spiegail rapporto dell’UFCS:“gli aggressori si spacciano per impiegati di unagrande banca, visto che la probabilità che la vittima vi abbiaeffettivamente un conto è statisticamente più alta”.In altre parole, tirano aindovinare e spesso ci azzeccano.E se sbagliano, diceil rapporto, “nelcorso della telefonata cercano di scoprire quale sia l’istitutobancario della vittima e quindi richiamano poco tempo dopo, ma questavolta a nome della banca «giusta».”

E leloro astuzie non finiscono qui: l’UFCScita infattiil caso di una vittima alla quale il sedicenteimpiegato di banca ha chiesto se negli ultimi giorni avessepredisposto un pagamento di una somma consistente afavore di una specifica persona, di cui il finto impiegato ha citatonome e cognome. La vittima conoscevaeffettivamente quella persona: come facevano i truffatori ad avereun’informazione così precisa e apparentemente rassicurante?

L’UFCSha scoperto che “siail nome che il numero di telefono della vittima e del presuntodestinatario erano comparsi in una presentazione pubblica che i dueavevano effettuato insieme in passato. Questo dimostra che gliaggressori spulciano sistematicamente Internet alla ricerca diinformazioni che possono poi sfruttare per attacchi di socialengineering mirati.”

Il social engineeringè quella tecnica di attaccoinformatico che si basa sul conquistare la fiducia della vittimamostrando di conoscere informazioni che in apparenza solo un veroimpiegato di banca o di un’azienda potrebbe avere. Ma le nostrevite sono sempre più pubbliche e condivise, grazieanche alla quantità di informazioni che noi stessi riversiamo neisocial network, e i criminali sanno come trovarle e sfruttarle controdi noi. Anchequi, sapere che i criminali non pescano a caso ma anzi spesso sistudiano bene la vittima è il primo passo verso la prevenzione.

Ilrapporto dell’UFCS prosegue con la descrizione di molti altri tipidi attacco, anche a livello internazionale e in situazioni di guerra,e con le raccomandazioni sucome difendersi bene. Maqueste sono storie che meritano di essere raccontate per bene in unapuntata a parte.

Scritto da Paolo Attivissimo per il blog Il Disinformatico. Ripubblicabile liberamente se viene inclusa questa dicitura (dettagli). Sono ben accette le donazioni Paypal.May 4, 2024

Antibufala: la misteriosa “raccomandata elettronica” da TIM non è una truffa o un malware

Ultimo aggiornamento: 2024/05/04 13:05.

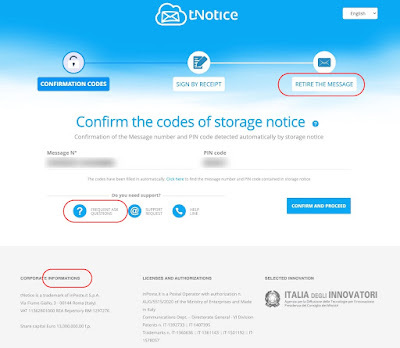

Ultimo aggiornamento: 2024/05/04 13:05.Se avete ricevuto una mail contenente un “Avviso di giacenza posta raccomandata” spedito da Tnotice.com etichettata “Per conto di TIM S.p.A.” e avete sospettato che si trattasse di una truffa o di un tentativo di attacco informatico, non siete i soli e non avete tutti i torti.

Già un mittente strano come Tnotice.com fa insospettire, ma il messaggio contiene anche gli errori dilettanteschi sono tipici delle mail dei truffatori:

no replay al posto di no reply (nella mail)retire the message come traduzione maccheronica di ritira il messaggio (to retire significa “pensionare”)frequent ask questions al posto di frequently asked questions informations, che persino uno studente al primo anno d’inglese sa che non ha il plurale (è un uncountable)

A chi ha confezionato e approvato questa roba andrebbe regalata una canna da pesca insieme a un prepensionamento anticipato in modo che non possa più fare altri danni.

Fra l’altro, questa “raccomandata elettronica” può essere ritirata da chiunque abbia la mail ricevuta: basta dare un numero di telefono qualsiasi per ricevere via SMS il codice di accesso.

Se volete sapere cosa contiene questa “raccomandata”, ecco il testo che ho ricevuto io: un paragrafo unico di burocratese stretto che parla di un possibile rimborso per la pratica delle bollette con periodicità di 28 giorni.

Scritto da Paolo Attivissimo per il blog Il Disinformatico. Ripubblicabile liberamente se viene inclusa questa dicitura (dettagli). Sono ben accette le donazioni Paypal.

Oggetto: TIM Informa

Il Tribunale di Milano, Sezione Undicesima Civile, all’esito dell’azione ordinaria promossa da Associazione Movimento Consumatori, ha inibito a TELECOM ITALIA S.P.A. l’adozione, l’uso e gli effetti nei contratti di telefonia fissa (o di altri servizi offerti in abbinamento alla telefonia fissa) stipulati con i consumatori, di clausole che prevedono rinnovi e pagamenti su base temporale di 28 giorni/8 settimane. L’adozione e l’uso di tale periodicità, a far data dal 01.04.2017, ha leso e lede i diritti e gli interessi collettivi dei consumatori, previsti dall’art. 2 Codice del consumo (1: diritto ad un’adeguata informazione ed ad una corretta pubblicità; 2: diritto a pratiche commerciali improntate a principi di buona fede, correttezza e lealtà; 3: diritto alla correttezza, alla trasparenza ed all’equità nei rapporti contrattuali) con violazione anche dei contenuti informativi minimi e del principio di trasparenza, previsti a favore dei consumatori utenti di servizi telefonici dagli artt. 70 e 71 Codice delle comunicazioni elettroniche. Tale condotta si risolve altresì in una pratica commerciale scorretta ingannevole, vietata dall’art. 20 Codice del consumo, in quanto l’adozione di tale periodicità (28 giorni), diversa da quella d’uso, risulta contraria alla diligenza professionale ed è idonea a falsare in maniera apprezzabile il comportamento economico del consumatore medio, rendendo difficile la valutazione delle offerte ed il confronto tra le medesime, anche ai fini dell’esercizio della facoltà di recesso gratuito, prevista dalla legge in caso di mutamento unilaterale delle condizioni del servizio da parte dell’operatore telefonico. L’illegittimità della condotta sopra descritta comporta il diritto di ciascun consumatore che abbia subito, nell’ambito di un contratto di telefonia fissa (o di altri servizi offerti in abbinamento alla telefonia fissa), l’adozione della periodicità di fatturazione a 28 giorni/8 settimane, alla ripetizione delle somme indebitamente corrisposte.

Puoi effettuare la tua richiesta on line dalla Home Page del sito tim.it nella sezione «TIM Sempre al tuo fianco» compilando il modulo dedicato, indicando il seguente codice unico [omissis].

May 2, 2024

Podcast RSI - Smart TV blocca Windows, antivirus che infetta, Corea del Nord nei cartoni di Amazon

È disponibile subito il podcast di oggi de Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto: lo trovate qui sul sito della RSI (si apre in una finestra/scheda separata) e lo potete scaricare .

Le puntate del Disinformatico sono ascoltabili anche tramite iTunes, Google Podcasts, Spotify e feed RSS.

Buon ascolto, e se vi interessano il testo di accompagnamento e i link alle fonti di questa puntata, sono qui sotto.

---

[CLIP: Inno nazionale nordcoreano]

Riconoscete questo inno nazionale? È quello di un paese che ha 26 milioni di abitanti e possiede in tutto circa trenta siti Internet. Sì, avete sentito bene: trenta. È la Corea del Nord, che è al centro di due delle tre storie strane dal mondo informatico di questa puntata del Disinformatico, il podcast della Radiotelevisione Svizzera dedicato appunto alle notizie e alle storie insolite dell’informatica. La terza storia, invece, riguarda le smart TV che fanno impazzire i PC Windows e soprattutto i loro utenti, creando guasti misteriosi. Benvenuti alla puntata del 3 maggio 2024. Io sono Paolo Attivissimo.

[SIGLA di apertura]

La smart TV che fa impazzire i PC WindowsLe cosiddette “smart TV”, ossia praticamente ogni modello di televisore recente, non sono affatto televisori nel senso tradizionale del termine. Non sono più apparecchi passivi, che ricevono un segnale via cavo o via etere e lo presentano sullo schermo: sono veri e propri computer, carrozzati come se fossero televisori, e quindi hanno tutti i pregi ma anche tutte le magagne dei computer. Solo che spesso ce ne dimentichiamo: li compriamo, sempre più grandi, più nitidi, li colleghiamo a Internet, e non ci pensiamo più.

Ci ha dovuto pensare, e ha dovuto farlo a lungo, Priscilla Snow, che è una musicista e audio designer che vive a Montreal, in Canada e racconta la sua strana avventura in un post su Cohost.org. Il suo PC Windows faceva le bizze in maniera insolita: le impostazioni video erano inaccessibili, un’interfaccia per una tastiera MIDI aveva smesso di funzionare, le schede di acquisizione video avevano problemi a connettersi, e altre cose di questo genere. Tutti malfunzionamenti di un tipo che ogni utente Windows conosce bene: quello che compare senza motivo e a volte scompare o si risolve senza motivo, e si sopporta perché.... perché i computer sono fatti così. Un riavvio, una reinstallazione di un driver, e passa la paura.

Priscilla Snow narra il suo caso come un racconto giallo, spiegando che a un certo punto le è scomparsa dal PC la Taskbar, cioè la barra delle applicazioni, cosa che le rendeva praticamente impossibile usare il computer, per cui ha proceduto alla maniera solita: ha aggiornato i driver e riavviato il PC.

La barra delle applicazioni è tornata, ma sei giorni dopo il problema si è ripresentato pari pari. A quel punto, esasperata dalla lunga serie di magagne, è andata a caccia di soluzioni e ha trovato su Reddit una discussione che descriveva gli stessi sintomi capitati a un altro utente Windows, che ne dava la colpa alla sua smart TV della marca Hisense.

Indovinate di che marca era la smart TV di Priscilla.

Secondo le informazioni pubblicate dall’altro utente Windows su un forum di supporto tecnico di Microsoft, i televisori di questa marca si annunciano continuamente sulla rete locale come se fossero nuovi dispositivi con un identificativo sempre differente (tecnicamente generano degli UUID casuali per i servizi di rete UPNP), e Windows diligentemente aggiunge tutti questi nuovi identificativi alle proprie liste di dispositivi.

Ma a furia di aggiungere dispositivi ogni qualche minuto, queste liste diventano enormi e ingestibili e Windows comincia a malfunzionare. Ovviamente non dice qualcosa di utile tipo “la lista dei dispositivi è troppo grande e va vuotata”, ma manifesta sintomi che mai e poi mai un utente normale collegherebbe a una smart TV che ha chiari problemi di identità e continua a cambiare nome.

Per risolvere il problema è necessario cancellare faticosamente centinaia di chiavi dal Registro di Windows e poi disabilitare la configurazione automatica dei dispositivi di rete nelle impostazioni di Windows. La musicista trasformatasi in detective del PC lo ha fatto e tutto ha ripreso a funzionare perfettamente. Una soluzione alternativa è non collegare mai la smart TV della Hisense alla rete locale ma darle una connessione separata oppure, meglio ancora, non comprarla affatto, dice.

Morale della storia: conviene sempre collegare alla rete di lavoro solo i dispositivi strettamente indispensabili e isolare tutti gli altri, e bisogna ricordare che a volte i problemi di Windows non sono colpa di Windows ma di altri dispositivi che non verrebbe mai in mente di considerare colpevoli. Oltre che studiare informatica, bisogna studiare anche le tecniche del tenente Colombo.

Fonte aggiuntiva: Ars Technica.

Se l’infezione arriva tramite l’antivirusMolti pensano che gli antivirus siano tutti uguali e scelgono il primo che trovano, magari quello preinstallato sul computer o quello proposto dal negoziante al momento dell’acquisto del computer. Ma non è sempre così, e la scelta va fatta con attenzione, evitando soprattutto di fidarsi di pubblicità o inviti che si incontrano online, perché l’antivirus è uno dei pochi software che per necessità deve avere il controllo totale del computer o del dispositivo in generale e quindi è in una posizione di potere molto speciale, ed è molto vulnerabile. È una posizione di cui qualcuno potrebbe approfittare.

È infatti emerso che eScan, un servizio antivirus basato in India, ha diffuso i propri aggiornamenti usando un metodo non sicuro (cioè il vecchio protocollo HTTP al posto del moderno HTTPS protetto dalla crittografia) e non ha protetto questi aggiornamenti con una firma digitale che li avrebbe autenticati, e ha continuato a farlo per cinque anni.

Due errori davvero dilettanteschi, che hanno permesso a degli aggressori informatici di sostituire gli aggiornamenti autentici con delle versioni modificate, che installavano sui computer degli utenti di questo antivirus una backdoor, ossia un programma che dava pieno accesso remoto nascosto a quei computer.

In pratica gli utenti di eScan credevano di scaricare un antivirus che li proteggeva e invece scaricavano un malware che li infettava e che in alcuni casi usava i loro computer e la loro bolletta elettrica per generare criptovalute a favore degli aggressori, probabilmente legati al governo nordcoreano, che ha generato miliardi di dollari di criptovalute usando malware installato sui dispositivi di vittime inconsapevoli (Ars Technica).

La scoperta di questo difetto imbarazzante di eScan è stata annunciata da un’altra azienda del settore, Avast (o come dicono molti àvast), a fine aprile, ed è stata confermata dalle autorità informatiche nazionali indiane. Ora eScan ha risolto il problema, ma il danno sui computer dei suoi utenti resta.

E il modo migliore per eliminarlo è usare un altro antivirus, sperando naturalmente di non cadere dalla padella nella brace.

La Corea del Nord fa soldi illeciti con i cartoni animati di AmazonC’è un paese che ha 26 milioni di abitanti e circa trenta siti Internet in tutto. È la Corea del Nord, dove pochissime persone possono usare Internet e quelle poche possono farlo solo per un’ora per volta e devono avere accanto qualcuno che approva la loro attività ogni cinque minuti, secondo le testimonianze raccolte da Wired.com.

Gli studiosi che scandagliano la minuscola presenza Internet di questo paese hanno scoperto una stranezza: degli animatori nordcoreani collaborano di nascosto alla produzione di serie televisive animate di Amazon e Max, eludendo le sanzioni internazionali e portando valuta estera preziosa al governo locale.

La scoperta è stata fatta grazie a un errore delle impostazioni di sicurezza di un sito nordcoreano, come descritto dettagliatamente in un rapporto liberamente scaricabile presso 38north.org. L'errore permetteva a chiunque, anche senza password di accesso, di osservare il traffico di dati su questo sito, che era un server per servizi cloud, uno dei tanti usati per lo scambio di dati dagli utenti informatici nordcoreani, che normalmente non hanno accesso diretto a Internet.

Tenendo d’occhio questo server maldestramente esposto, i ricercatori hanno notato che ogni giorno vi compariva una serie di file che includevano bozzetti e istruzioni particolareggiate di lavorazione non per armi o per altre cose tipicamente associate al governo nordcoreano, ma per cartoni animati, comprese serie popolari come Invincible di Amazon o Octonauts della BBC e molte altre.

A quanto pare, insomma, le case di produzione occidentali, a furia di subappaltare i progetti, finiscono per affidarsi a fornitori cinesi, che a loro volta subappaltano a ditte nordcoreane, aggirando così le sanzioni internazionali che vietano collaborazioni di questo tipo. Queste case di produzione dicono di essere inconsapevoli di questa situazione.

Lo scopo, secondo gli esperti osservatori dell’Internet nordcoreana, è portare soldi nelle casse dello stato e finanziare le sue ambizioni militari. Si sapeva già che i criminali informatici del paese usano attacchi legati alle criptovalute per guadagnare denaro per il regime e che gli informatici nordcoreani si fanno assumere dalle aziende statunitensi e di altri paesi come lavoratori remoti fingendo di essere giapponesi (Japan Times) o cinesi (Treasury.gov) e poi girano i propri compensi al governo. Ora salta fuori che guardando un cartone animato su Amazon c’è il rischio di finanziare le armi di una dittatura. Viviamo decisamente in tempi interessanti e surreali.

Fonte aggiuntiva: Ars Technica.

Scritto da Paolo Attivissimo per il blog Il Disinformatico. Ripubblicabile liberamente se viene inclusa questa dicitura (dettagli). Sono ben accette le donazioni Paypal.April 26, 2024

L’intelligenza artificiale e la fiducia, di Bruce Schneier

Questa è la mia traduzione integrale del saggio AI and Trust di Bruce Schneier, realizzata e pubblicata con il suo permesso. Una sintesi è pubblicata nel mio podcast. È disponibile anche una traduzione in tedesco, pubblicata da Netzpolitik.org.

L’intelligenza artificiale e la fiducia, di Bruce SchneierOggi mi sono fidato molto. Mi sono fidato che il mio telefono mi avrebbe svegliato in tempo. Mi sono fidato che Uber avrebbe predisposto un taxi per me e che il tassista mi avrebbe portato sano e salvo in aeroporto. Mi sono fidato che migliaia di altri conducenti per strada non avrebbero tamponato la mia auto. All’aeroporto mi sono fidato dei controllori al check-in, dei tecnici addetti alla manutenzione, di tutte le altre persone che mantengono operativa una compagnia aerea, del pilota dell’aereo sul quale ho volato, e di migliaia di altre persone in aeroporto e sull’aereo, ciascuna delle quali avrebbe potuto aggredirmi. E mi sono fidato di tutte le persone che mi hanno preparato e servito la colazione, e dell’intera filiera alimentare: qualunque anello di questa catena avrebbe potuto avvelenarmi. Quando sono atterrato qui, mi sono fidato di altre migliaia di persone: in aeroporto, sulla strada, in questo edificio, in questa sala. E tutto questo è avvenuto prima delle 10.30 di stamattina.

La fiducia è essenziale per la società. Gli esseri umani, come specie, tendono a fidarsi gli uni degli altri. Siamo tutti seduti qui, e per la maggior parte non ci conosciamo fra noi, e siamo fiduciosi del fatto che nessuno ci aggredirà. Se questa fosse una sala piena di scimpanzé, questo sarebbe impossibile. Noi ci fidiamo migliaia di volte al giorno. La società non potrebbe funzionare senza la fiducia. E il fatto che non ci facciamo neanche caso è una misura di quanto funzioni bene tutto questo.

In questo mio intervento proporrò numerose argomentazioni. La prima è che esistono due tipi differenti di fiducia, quella interpersonale e quella sociale, e che li confondiamo continuamente. La seconda è che questa confusione aumenterà con l’intelligenza artificiale: commetteremo un errore di categorizzazione fondamentale e penseremo alle intelligenze artificiali come amiche quando sono in realtà solo servizi. La terza è che le aziende che controllano i sistemi di intelligenza artificiale si approfitteranno della nostra confusione per sfruttarci e non saranno degne di fiducia. La quarta è che è compito del governo creare la fiducia nella società e quindi creare un ambiente che consenta una IA degna di fiducia. Questo comporta della regolamentazione: non dell’IA, ma delle organizzazioni che controllano e utilizzano l’IA.

Bene, facciamo un passo indietro e consideriamo tutte queste cose molto più lentamente. La fiducia è un concetto complicato e questa parola è sovraccarica di tanti significati. C’è la fiducia personale e intima. Quando diciamo che ci fidiamo di un amico o di un’amica, è più per com’è quella persona che per le cose specifiche che fa. Confidiamo che si comporterà in maniera degna di fiducia, ci fidiamo delle sue intenzioni e sappiamo che quelle intenzioni ispireranno le sue azioni. Questa possiamo chiamarla “fiducia interpersonale”.

Esiste anche la fiducia meno intima, meno personale. Magari non conosciamo qualcuno di persona oppure non ne conosciamo le motivazioni, ma possiamo fidarci del suo comportamento. Non sappiamo se qualcuno vuole derubarci oppure no, ma forse possiamo fidarci che non lo faranno. È più una questione di affidabilità e prevedibilità. Questa possiamo chiamarla “fiducia sociale”: la capacità di fidarsi degli sconosciuti.

La fiducia interpersonale e quella sociale sono entrambe essenziali nella società attuale. Funziona così: abbiamo meccanismi che inducono le persone a comportarsi in maniera degna di fiducia, sia a livello interpersonale, sia a livello sociale. Questo, a sua volta, permette agli altri di avere e dare fiducia, e questo rende possibile la fiducia nella società, e tutto questo permette alla società di continuare a funzionare. Il sistema non è perfetto: ci saranno sempre persone che abusano della nostra fiducia, ma il fatto che la maggior parte di noi sia degna di fiducia per la maggior parte del tempo è sufficiente.

Ho parlato di questi concetti nel 2012, in un libro intitolato Liars and Outliers, descrivendo quattro sistemi che rendono possibile la fiducia: i nostri valori morali innati, la preoccupazione per le nostre reputazioni, le leggi alle quali siamo soggetti e le tecnologie di sicurezza che vincolano il nostro comportamento. Ho scritto che le prime due sono più informali delle due successive, e che queste due successive sono più scalabili, consentono società più grandi e più complesse e rendono possibile la cooperazione tra sconosciuti.

Quello che non avevo considerato è quanto siano differenti le prime due dalle seconde. I valori morali e la reputazione valgono tra una persona e un’altra, sulla base dei rapporti umani, della reciproca vulnerabilità, sul rispetto, l’integrità, la generosità e molte altre cose, che sono i fondamenti della fiducia interpersonale. Le leggi e le tecnologie di sicurezza sono sistemi di fiducia che ci obbligano a comportarci in modo degno di fiducia, e costituiscono la base della fiducia sociale.

Fare il tassista una volta era uno dei mestieri più pericolosi in questo paese. Uber ha cambiato tutto. Non conosco il mio conducente Uber, ma le regole e la tecnologia danno a me e a lui la fiducia che nessuno di noi cercherà di truffare o attaccare l’altro. Siamo entrambi sotto continua sorveglianza e siamo in competizione per avere punteggi elevati.

Molta gente scrive a proposito della differenza tra vivere in una società che ha un livello di fiducia elevato e vivere in una che ha un livello basso, dicendo che l’affidabilità e la prevedibilità rendono tutto più semplice, e notando cosa si perde quando la società non ha queste caratteristiche. Si parla anche di come le società passano da livelli alti di fiducia a livelli bassi, e viceversa. Tutto questo si basa sulla fiducia sociale.

Questa letteratura è importante, ma per questo mio discorso il punto centrale è che la fiducia sociale è maggiormente scalabile [nel senso di “usabile su scala più ampia”, N.d.T.]. Un tempo serviva avere un rapporto personale con un funzionario di banca per ottenere un prestito. Oggi tutto questo si fa algoritmicamente e ci sono molte più opzioni tra cui scegliere.

La fiducia sociale è maggiormente scalabile ma incorpora ogni sorta di pregiudizio e preconcetto, perché per poter essere scalable deve essere strutturata, orientata ai sistemi e alle regole, ed è a questo punto che vengono incorporati i pregiudizi. Inoltre il sistema deve essere reso quasi completamente insensibile al contesto, e questo gli toglie flessibilità.

Ma questa scala è fondamentale. Nella società attuale diamo regolarmente fiducia a governi, aziende, organizzazioni o gruppi, oppure ne diffidiamo. Non è che mi sono fidato dello specifico pilota che ha fatto volare il mio aereo; mi sono fidato della compagnia aerea, che mette in cabina di pilotaggio piloti ben addestrati e ben riposati. Non mi fido dei cuochi o camerieri al ristorante, ma semmai del sistema di norme sanitarie al quale sono soggetti. Non sono nemmeno in grado di descrivere il sistema bancario di cui mi sono fidato quando ho usato un Bancomat stamattina. Ancora una volta, questa fiducia non è altro che affidabilità e prevedibilità.

Pensate di nuovo a quel ristorante. Immaginate che sia un fast food che dà lavoro a dei teenager. Il cibo è quasi certamente sicuro – probabilmente più sicuro che in molti ristoranti di alto livello –– a causa dei sistemi aziendali o dell’affidabilità e prevedibilità che guida ogni loro comportamento.

È qui che sta la differenza. Potete chiedere a un amico di consegnare un pacchetto dall’altra parte della città, oppure potete chiedere alle Poste di fare la stessa cosa. Nel primo caso si tratta di fiducia interpersonale, basata sulla moralità e sulla reputazione. Conoscete il vostro amico e sapete quanto è affidabile. Nel secondo abbiamo un servizio, reso possibile dalla fiducia sociale. E nella misura in cui è un servizio affidabile e prevedibile, si basa principalmente su leggi e tecnologie. Entrambi i metodi possono consegnare il vostro pacchetto, ma solo il secondo può diventare il sistema di corrieri di portata mondiale che è FedEx.

A causa dell’ampiezza e della complessità della società, abbiamo sostituito molti dei rituali e dei comportamenti tipici della fiducia interpersonale con meccanismi di sicurezza che garantiscono affidabilità e prevedibilità: la fiducia sociale.

Ma poiché usiamo lo stesso termine “fiducia” per entrambi, li confondiamo regolarmente. E quando lo facciamo, commettiamo un errore di categorizzazione.

Lo facciamo continuamente: con i governi, con le organizzazioni, con i sistemi di tutti i tipi, e soprattutto con le aziende.

Possiamo pensare a loro come amiche, quando in realtà sono servizi. Le aziende non sono morali; sono immorali, nella misura in cui la legge e la loro reputazione gliela fanno passare liscia.

[IN LAVORAZIONE da qui in poi]

So corporations regularly take advantage of their customers, mistreat their workers, pollute the environment, and lobby for changes in law so they can do even more of these things.

Both language and the laws make this an easy category error to make. We use the same grammar for people and corporations. We imagine that we have personal relationships with brands. We give corporations some of the same rights as people.

Corporations like that we make this category error—see, I just made it myself—because they profit when we think of them as friends. They use mascots and spokesmodels. They have social media accounts with personalities. They refer to themselves like they are people.

But they are not our friends. Corporations are not capable of having that kind of relationship.

We are about to make the same category error with AI. We’re going to think of them as our friends when they’re not.

A lot has been written about AIs as existential risk. The worry is that they will have a goal, and they will work to achieve it even if it harms humans in the process. You may have read about the “paperclip maximizer“: an AI that has been programmed to make as many paper clips as possible, and ends up destroying the earth to achieve those ends. It’s a weird fear. Science fiction author Ted Chiang writes about it. Instead of solving all of humanity’s problems, or wandering off proving mathematical theorems that no one understands, the AI single-mindedly pursues the goal of maximizing production. Chiang’s point is that this is every corporation’s business plan. And that our fears of AI are basically fears of capitalism. Science fiction writer Charlie Stross takes this one step further, and calls corporations “slow AI.” They are profit maximizing machines. And the most successful ones do whatever they can to achieve that singular goal.

And near-term AIs will be controlled by corporations. Which will use them towards that profit-maximizing goal. They won’t be our friends. At best, they’ll be useful services. More likely, they’ll spy on us and try to manipulate us.

This is nothing new. Surveillance is the business model of the Internet. Manipulation is the other business model of the Internet.

Your Google search results lead with URLs that someone paid to show to you. Your Facebook and Instagram feeds are filled with sponsored posts. Amazon searches return pages of products whose sellers paid for placement.

This is how the Internet works. Companies spy on us as we use their products and services. Data brokers buy that surveillance data from the smaller companies, and assemble detailed dossiers on us. Then they sell that information back to those and other companies, who combine it with data they collect in order to manipulate our behavior to serve their interests. At the expense of our own.

We use all of these services as if they are our agents, working on our behalf. In fact, they are double agents, also secretly working for their corporate owners. We trust them, but they are not trustworthy. They’re not friends; they’re services.

It’s going to be no different with AI. And the result will be much worse, for two reasons.

The first is that these AI systems will be more relational. We will be conversing with them, using natural language. As such, we will naturally ascribe human-like characteristics to them.

This relational nature will make it easier for those double agents to do their work. Did your chatbot recommend a particular airline or hotel because it’s truly the best deal, given your particular set of needs? Or because the AI company got a kickback from those providers? When you asked it to explain a political issue, did it bias that explanation towards the company’s position? Or towards the position of whichever political party gave it the most money? The conversational interface will help hide their agenda.

The second reason to be concerned is that these AIs will be more intimate. One of the promises of generative AI is a personal digital assistant. Acting as your advocate with others, and as a butler with you. This requires an intimacy greater than your search engine, email provider, cloud storage system, or phone. You’re going to want it with you 24/7, constantly training on everything you do. You will want it to know everything about you, so it can most effectively work on your behalf.

And it will help you in many ways. It will notice your moods and know what to suggest. It will anticipate your needs and work to satisfy them. It will be your therapist, life coach, and relationship counselor.

You will default to thinking of it as a friend. You will speak to it in natural language, and it will respond in kind. If it is a robot, it will look humanoid—or at least like an animal. It will interact with the whole of your existence, just like another person would.

The natural language interface is critical here. We are primed to think of others who speak our language as people. And we sometimes have trouble thinking of others who speak a different language that way. We make that category error with obvious non-people, like cartoon characters. We will naturally have a “theory of mind” about any AI we talk with.

More specifically, we tend to assume that something’s implementation is the same as its interface. That is, we assume that things are the same on the inside as they are on the surface. Humans are like that: we’re people through and through. A government is systemic and bureaucratic on the inside. You’re not going to mistake it for a person when you interact with it. But this is the category error we make with corporations. We sometimes mistake the organization for its spokesperson. AI has a fully relational interface—it talks like a person—but it has an equally fully systemic implementation. Like a corporation, but much more so. The implementation and interface are more divergent than anything we have encountered to date—by a lot.

And you will want to trust it. It will use your mannerisms and cultural references. It will have a convincing voice, a confident tone, and an authoritative manner. Its personality will be optimized to exactly what you like and respond to.

It will act trustworthy, but it will not be trustworthy. We won’t know how they are trained. We won’t know their secret instructions. We won’t know their biases, either accidental or deliberate.

We do know that they are built at enormous expense, mostly in secret, by profit-maximizing corporations for their own benefit.

It’s no accident that these corporate AIs have a human-like interface. There’s nothing inevitable about that. It’s a design choice. It could be designed to be less personal, less human-like, more obviously a service—like a search engine . The companies behind those AIs want you to make the friend/service category error. It will exploit your mistaking it for a friend. And you might not have any choice but to use it.

There is something we haven’t discussed when it comes to trust: power. Sometimes we have no choice but to trust someone or something because they are powerful. We are forced to trust the local police, because they’re the only law enforcement authority in town. We are forced to trust some corporations, because there aren’t viable alternatives. To be more precise, we have no choice but to entrust ourselves to them. We will be in this same position with AI. We will have no choice but to entrust ourselves to their decision-making.

The friend/service confusion will help mask this power differential. We will forget how powerful the corporation behind the AI is, because we will be fixated on the person we think the AI is.

So far, we have been talking about one particular failure that results from overly trusting AI. We can call it something like “hidden exploitation.” There are others. There’s outright fraud, where the AI is actually trying to steal stuff from you. There’s the more prosaic mistaken expertise, where you think the AI is more knowledgeable than it is because it acts confidently. There’s incompetency, where you believe that the AI can do something it can’t. There’s inconsistency, where you mistakenly expect the AI to be able to repeat its behaviors. And there’s illegality, where you mistakenly trust the AI to obey the law. There are probably more ways trusting an AI can fail.

All of this is a long-winded way of saying that we need trustworthy AI. AI whose behavior, limitations, and training are understood. AI whose biases are understood, and corrected for. AI whose goals are understood. That won’t secretly betray your trust to someone else.

The market will not provide this on its own. Corporations are profit maximizers, at the expense of society. And the incentives of surveillance capitalism are just too much to resist.

It’s government that provides the underlying mechanisms for the social trust essential to society. Think about contract law. Or laws about property, or laws protecting your personal safety. Or any of the health and safety codes that let you board a plane, eat at a restaurant, or buy a pharmaceutical without worry.

The more you can trust that your societal interactions are reliable and predictable, the more you can ignore their details. Places where governments don’t provide these things are not good places to live.

Government can do this with AI. We need AI transparency laws. When it is used. How it is trained. What biases and tendencies it has. We need laws regulating AI—and robotic—safety. When it is permitted to affect the world. We need laws that enforce the trustworthiness of AI. Which means the ability to recognize when those laws are being broken. And penalties sufficiently large to incent trustworthy behavior.

Many countries are contemplating AI safety and security laws—the EU is the furthest along—but I think they are making a critical mistake. They try to regulate the AIs and not the humans behind them.

AIs are not people; they don’t have agency. They are built by, trained by, and controlled by people. Mostly for-profit corporations. Any AI regulations should place restrictions on those people and corporations. Otherwise the regulations are making the same category error I’ve been talking about. At the end of the day, there is always a human responsible for whatever the AI’s behavior is. And it’s the human who needs to be responsible for what they do—and what their companies do. Regardless of whether it was due to humans, or AI, or a combination of both. Maybe that won’t be true forever, but it will be true in the near future. If we want trustworthy AI, we need to require trustworthy AI controllers.

We already have a system for this: fiduciaries. There are areas in society where trustworthiness is of paramount importance, even more than usual. Doctors, lawyers, accountants…these are all trusted agents. They need extraordinary access to our information and ourselves to do their jobs, and so they have additional legal responsibilities to act in our best interests. They have fiduciary responsibility to their clients.

We need the same sort of thing for our data. The idea of a data fiduciary is not new. But it’s even more vital in a world of generative AI assistants.

And we need one final thing: public AI models. These are systems built by academia, or non-profit groups, or government itself, that can be owned and run by individuals.

The term “public model” has been thrown around a lot in the AI world, so it’s worth detailing what this means. It’s not a corporate AI model that the public is free to use. It’s not a corporate AI model that the government has licensed. It’s not even an open-source model that the public is free to examine and modify.

A public model is a model built by the public for the public. It requires political accountability, not just market accountability. This means openness and transparency paired with a responsiveness to public demands. It should also be available for anyone to build on top of. This means universal access. And a foundation for a free market in AI innovations. This would be a counter-balance to corporate-owned AI.

We can never make AI into our friends. But we can make them into trustworthy services—agents and not double agents. But only if government mandates it. We can put limits on surveillance capitalism. But only if government mandates it.

Because the point of government is to create social trust. I started this talk by explaining the importance of trust in society, and how interpersonal trust doesn’t scale to larger groups. That other, impersonal kind of trust—social trust, reliability and predictability—is what governments create.

To the extent a government improves the overall trust in society, it succeeds. And to the extent a government doesn’t, it fails.

But they have to. We need government to constrain the behavior of corporations and the AIs they build, deploy, and control. Government needs to enforce both predictability and reliability.

That’s how we can create the social trust that society needs to thrive.

Scritto da Paolo Attivissimo per il blog Il Disinformatico. Ripubblicabile liberamente se viene inclusa questa dicitura (dettagli). Sono ben accette le donazioni Paypal.Podcast RSI - Perché l’intelligenza artificiale ci seduce? Lo spiega l’esperto mondiale Bruce Schneier

È disponibile subito il podcast di oggi de Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto: lo trovate qui sul sito della RSI (si apre in una finestra/scheda separata) e lo potete scaricare .

Le puntate del Disinformatico sono ascoltabili anche tramite iTunes, Google Podcasts, Spotify e feed RSS.

---

[CLIP: Discussione finale fra HAL e David Bowman da “2001 Odissea nello spazio” (1968)]

È facile considerare l’intelligenza artificiale come nient’altro che l’ennesima novità tecnologica, uno strumento informatico in più, un ausilio al quale ci abitueremo presto. Nessuno si è agitato o ha proclamato la catastrofe sociale per l’introduzione del controllo ortografico o del riconoscimento vocale. Quindi perché così tanto clamore, e in alcuni casi panico, proprio intorno all’intelligenza artificiale?

L'esperto di sicurezza informatica Bruce Schneier, autore di numerosi libri sulle tematiche digitali e membro del direttivo della Electronic Frontier Foundation, una delle associazioni di punta nella tutela dei diritti digitali, ha pubblicato un saggio, intitolato AI and Trust, nel quale spiega molto bene questa anomalia partendo da un concetto sociale, non tecnologico: la fiducia. E spiega perché noi, come esseri umani, siamo particolarmente vulnerabili alla natura seducente dell’intelligenza artificiale.

Le sue parole sono al centro della puntata del 26 aprile 2024 del Disinformatico, il podcast della Radiotelevisione Svizzera dedicato alle notizie e alle storie strane dell’informatica. Benvenuti. Io sono Paolo Attivissimo.

[SIGLA di apertura]

Premessa: due tipi di fiducia da distinguere“La fiducia“, dice Bruce Schneier, “è essenziale per la società. Gli esseri umani, come specie, tendono a fidarsi gli uni degli altri.” Prendiamo un mezzo pubblico o camminiamo per strada dando per scontato di poterci fidare del conducente di quel veicolo e del fatto che non verremo aggrediti dai passanti. La fiducia è l’impostazione di default della società, per così dire.

E ci sono due tipi di fiducia: quella interpersonale, basata sulla conoscenza diretta di una persona, e quella sociale, basata sui meccanismi e sulle regole condivise che inducono le persone a comportarsi mediamente in modo affidabile. “Il sistema non è perfetto”, nota ovviamente Schneier: “ci saranno sempre persone che abusano della nostra fiducia, ma il fatto che la maggior parte di noi sia affidabile per la maggior parte del tempo è sufficiente. [...] Le leggi e le tecnologie di sicurezza sono sistemi di fiducia che ci obbligano a comportarci in modo affidabile”, consentendo società più grandi e complesse e permettendo la cooperazione tra sconosciuti.

Da qui in poi vi riporto in sintesi le parole chiarissime di Bruce Schneier, tradotte con il suo permesso. La traduzione integrale del suo saggio è disponibile presso Disinformatico.info.

A causa dell'ampiezza e della complessità della società, abbiamo sostituito molti dei rituali e dei comportamenti tipici della fiducia interpersonale con meccanismi di sicurezza che garantiscono affidabilità e prevedibilità, ossia la fiducia sociale. Ma poiché usiamo lo stesso termine “fiducia” per entrambi, li confondiamo regolarmente. E quando lo facciamo, commettiamo un errore di categorizzazione. Lo facciamo continuamente: con i governi, con le organizzazioni, con i sistemi di tutti i tipi, e soprattutto con le aziende. Possiamo pensare a loro come amiche, quando in realtà sono servizi. Le aziende non sono morali; sono immorali, nella misura in cui la legge e la loro reputazione gliela fanno passare liscia.

Di conseguenza, le aziende si approfittano regolarmente dei loro clienti, maltrattano i loro lavoratori, inquinano l’ambiente e fanno pressioni per modificare le leggi in modo da poter fare queste cose ancora di più.

Sia il linguaggio che le leggi, dice Schneier, rendono facile commettere questo errore di categorizzazione. Usiamo la stessa grammatica per le persone e le aziende. Immaginiamo di avere rapporti personali con i marchi. Diamo alle aziende alcuni degli stessi diritti che diamo alle persone.

Alle aziende piace che commettiamo questo errore di categoria (lo commette anche Schneier, scherzosamente, usando questo concetto di piacere). Piace perché traggono profitto quando pensiamo a loro come amiche. Utilizzano mascotte e testimonial. Hanno account sui social media, e questi account hanno una propria personalità. Si riferiscono a loro stesse come se fossero persone. Ma non sono nostre amiche: le aziende non sono in grado di avere questo tipo di relazione.

Stiamo per commettere lo stesso errore di categorizzazione con le intelligenze artificiali: le considereremo nostre amiche quando non lo sono.

La seduzione dell’IA, spiegataA questo punto del suo saggio, Bruce Schneier nota che le intelligenze artificiali del prossimo futuro saranno controllate dalle aziende, che le useranno per raggiungere l'obiettivo di massimizzare il profitto. Non saranno nostre amiche: nel caso migliore saranno servizi utili. Più probabilmente, ci spieranno e cercheranno di manipolarci.

Questa non è una novità. La sorveglianza e la manipolazione sono il modello di business di Internet. I risultati delle vostre ricerche in Google sono preceduti da link che qualcuno ha pagato per mostrare. I vostri feed di Facebook e Instagram sono pieni di post sponsorizzati. Le ricerche su Amazon restituiscono pagine di prodotti i cui venditori hanno pagato per essere piazzati in quelle pagine.

Questo è il modo in cui funziona Internet. Le aziende ci spiano mentre utilizziamo i loro prodotti e servizi. I broker di dati acquistano i dati di sorveglianza dalle aziende più piccole e creano dossier dettagliati su di noi. Poi rivendono queste informazioni a queste e altre aziende, che le combinano con i dati raccolti da loro per manipolare il nostro comportamento, al servizio dei loro interessi e a spese dei nostri interessi.

Utilizziamo tutti questi servizi come se fossero nostri agenti, che lavorano per noi. In realtà, sono agenti doppiogiochisti, che lavorano segretamente anche per i loro proprietari aziendali. Ci fidiamo di loro, ma non sono degni di fiducia. Non sono amici, sono servizi.

Non sarà diverso con l’intelligenza artificiale, e il risultato, secondo Bruce Schneier, sarà molto peggiore, per due motivi.

Il primo motivo è che questi sistemi di intelligenza artificiale saranno più relazionali. Converseremo con loro, utilizzando il linguaggio naturale. E così attribuiremo loro spontaneamente delle caratteristiche simili a quelle umane.

Questa natura relazionale renderà più facile il lavoro di questi doppiogiochisti. Il vostro chatbot vi ha consigliato una particolare compagnia aerea o un hotel perché è davvero l'offerta migliore, in base alle vostre particolari esigenze, o perché l'azienda di intelligenza artificiale ha ricevuto una tangente da quei fornitori? Quando gli avete chiesto di spiegare una questione politica, ha orientato la sua spiegazione verso la posizione dell'azienda o del partito politico che le ha dato più soldi? L'interfaccia conversazionale aiuterà a nascondere le loro intenzioni.

Il secondo motivo di preoccupazione è che queste intelligenze artificiali saranno più intime. Una delle promesse dell'intelligenza artificiale generativa è un assistente digitale personale, che agisce come vostro rappresentante verso gli altri e come maggiordomo con voi. Questo richiede un'intimità maggiore rispetto a un motore di ricerca, a un provider di e-mail, a un sistema di archiviazione cloud o a un telefono. Desidererete che questo assistente sia con voi 24 ore su 24, 7 giorni su 7, e che si istruisca costantemente su tutto ciò che fate. Sarete voi a volere che sappia tutto di voi, in modo da poter lavorare nel modo più efficace per vostro conto.

E questo assistente vi aiuterà in molti modi. Noterà i vostri stati d'animo e saprà cosa suggerirvi, anticiperà le vostre esigenze e lavorerà per soddisfarle. Sarà il vostro terapeuta, life coach e consulente relazionale.

Vi verrà spontaneo considerarlo un amico: vi rivolgerete a lui in linguaggio naturale, e lui farà lo stesso con voi. Se è un robot, avrà un aspetto umanoide o almeno simile a un animale. Interagirà con tutta la vostra esistenza, proprio come farebbe un’altra persona.

Il suo uso del linguaggio naturale è decisivo, in questo caso, perché siamo portati automaticamente a pensare agli altri che parlano la nostra lingua come persone, mentre a volte abbiamo problemi a trattare come persone chi parla una lingua diversa dalla nostra.

Prosegue Schneier:

[...] Vorrete fidarvi di questo assistente, che userà i vostri stessi modi di fare e riferimenti culturali, avrà una voce convincente, un tono sicuro e un modo di fare autorevole. La sua personalità sarà ottimizzata esattamente su ciò che vi piace e a cui reagite. Si comporterà in modo affidabile, ma non sarà affidabile. Non sapremo come è stata addestrata, quali sono le sue istruzioni segrete o i suoi pregiudizi, accidentali o intenzionali.

Sappiamo però che queste intelligenze artificiali vengono create con costi enormi, per lo più in segreto, da aziende che massimizzano il profitto per il proprio beneficio.

Non è un caso che queste intelligenze artificiali aziendali abbiano un'interfaccia simile a quella umana. Non è inevitabile: è una scelta progettuale. Le si potrebbe progettare per essere meno personali, meno simili all’essere umano, più dichiaratamente dei servizi, come i motori di ricerca. Le aziende che stanno dietro queste intelligenze artificiali sfrutteranno il fatto che le scambiamo per amiche, e potremmo non avere altra scelta che usarle.

Chi ci darà una IA affidabile?A volte, infatti, non abbiamo altra scelta che fidarci di qualcuno o qualcosa perché è potente, spiega Bruce Schneier. Siamo costretti a fidarci della polizia locale, perché è l'unica autorità di polizia in città. Siamo costretti a fidarci di alcune aziende, perché non ci sono alternative valide. Ci troveremo nella stessa posizione con e intelligenze artificiali: non avremo altra scelta che affidarci ai loro processi decisionali.

E la confusione fra amico e servizio aiuterà a mascherare questa disparità di potere. Dimenticheremo quanto sia potente l'azienda che sta dietro l'intelligenza artificiale, perché ci fisseremo sulla “persona” che pensiamo che l’intelligenza artificiale sia.

Schneier elenca poi alcuni modi in cui le intelligenze artificiali possono fallire.

C'è la frode vera e propria, in cui l’intelligenza artificiale sta effettivamente cercando di rubarvi qualcosa. C'è il più prosaico errore di competenza, in cui pensate che questa intelligenza artificiale sia più esperta di quanto non sia realmente, perché si comporta ostentando sicurezza. C'è l'incompetenza, quando si crede che l’intelligenza artificiale sia in grado di fare qualcosa che non è in grado di fare. C'è l'incoerenza, quando ci si aspetta erroneamente che una intelligenza artificiale sia in grado di ripetere i propri comportamenti. E c'è l'illegalità, quando si confida erroneamente anhe qui, che l'intelligenza artificiale rispetti la legge.

Tutto questo vuol dire che abbiamo bisogno di un'intelligenza artificiale affidabile, di cui si conoscano il comportamento, i limiti e la formazione, i cui pregiudizi siano compresi e corretti, di cui si capiscano gli obiettivi e che non tradirà segretamente la vostra fiducia a favore di qualcun altro.

Secondo Schneier,

[...] il mercato non fornirà spontaneamente queste cose, perché le aziende massimizzano i profitti, a spese della società. E gli incentivi del capitalismo di sorveglianza sono troppo forti per resistere. Sono invece i governi a fornire i meccanismi di base per la fiducia sociale, che è essenziale per la società. Pensiamo al diritto contrattuale, alle leggi sulla proprietà, alle leggi che proteggono la vostra sicurezza personale e a tutte le norme di salute e sicurezza che vi permettono di salire su un aereo, mangiare al ristorante o acquistare un farmaco senza preoccupazioni.

I governi possono fare tutto questo per l’intelligenza artificiale. Abbiamo bisogno di leggi sulla trasparenza dell'intelligenza artificiale: quando viene utilizzata, come viene addestrata, quali pregiudizi e tendenze ha. Ci servono leggi che regolino la sicurezza dell'intelligenza artificiale e della robotica e dicano quando è permesso che l’intelligenza artificiale abbia un impatto sul mondo. Abbiamo bisogno di leggi che impongano l'affidabilità dell'intelligenza artificiale, il che significa la capacità di riconoscere quando queste leggi vengono infrante. E servono sanzioni sufficientemente elevate da incentivare un comportamento affidabile.

Molti Paesi stanno valutando leggi sulla sicurezza delle intelligenze artificiali - l'Unione Europea è la più avanti - ma secondo Schneier si sta commettendo un errore cruciale: si cerca di regolamentare le intelligenze artificiali e non gli esseri umani che vi stanno dietro.

Se vogliamo un'intelligenza artificiale affidabile, dobbiamo richiedere controllori dell'intelligenza artificiale affidabili. Abbiamo già un sistema per queste cose: i fiduciari. [...] Medici, avvocati, commercialisti [...] sono tutti agenti di fiducia. Hanno bisogno di un accesso straordinario alle nostre informazioni e a noi stessi per svolgere il loro lavoro, e quindi hanno ulteriori responsabilità legali per agire nel nostro migliore interesse. Hanno una responsabilità fiduciaria nei confronti dei loro clienti.

Abbiamo bisogno della stessa cosa per i nostri dati. L'idea di un fiduciario dei dati non è nuova, ma è ancora più vitale in un mondo di assistenti di intelligenza artificiale generativi.

Modelli di IA pubbliciSecondo Schneier serve anche un’altra cosa: quelli che lui definisce modelli di intelligenza artificiale pubblici.

Sistemi costruiti dal mondo accademico, da gruppi non profit [nel podcast ho detto “no-profit”, ma è sbagliato] o dal governo stesso, che possono essere posseduti e gestiti dai singoli individui. Non si tratta di un modello di intelligenza artificiale aziendale che il pubblico è semplicemente libero di utilizzare. Non è un modello di intelligenza artificiale aziendale che il governo ha concesso in licenza. Non è nemmeno un modello open source che il pubblico è libero di esaminare e modificare. Un modello pubblico è un modello costruito dal pubblico per il pubblico. Richiede una responsabilità politica, non solo una responsabilità di mercato, dice Schneier. Ciò significa apertura e trasparenza, abbinate alla capacità di rispondere alle richieste del pubblico. Dovrebbe anche essere disponibile, quest’intelligenza artificiale, a chiunque per costruirci sopra. Ciò significa accesso universale, e costituisce una base per un libero mercato delle innovazioni nell’intelligenza artificiale. Tutto questo sarebbe un contrappeso all'intelligenza artificiale di proprietà delle aziende.

Il saggio di Schneier si conclude con questa riflessione:

Non potremo mai trasformare le intelligenze artificiali in nostri amici, ma possiamo trasformarle in servizi affidabili e non doppiogiochisti. Però possiamo farlo solo se il governo lo impone. Perché lo scopo del governo è creare fiducia sociale. Nella misura in cui un governo migliora la fiducia generale nella società, ha successo. E nella misura in cui non lo fa, fallisce. Abbiamo bisogno di un governo per limitare il comportamento delle aziende e delle intelligenze artificiali che le aziende costruiscono, distribuiscono e controllano. Il governo deve imporre sia prevedibilità che affidabilità.

È così che possiamo creare la fiducia sociale di cui la società ha bisogno per prosperare.

– Bruce Schneier, AI and Trust, dicembre 2023

Scritto da Paolo Attivissimo per il blog Il Disinformatico. Ripubblicabile liberamente se viene inclusa questa dicitura (dettagli). Sono ben accette le donazioni Paypal.April 19, 2024

Podcast RSI - Story: La beffa dei cookie rifiutati

Ultimo aggiornamento: 2024/04/19 20:45.

È disponibile subito il podcast di oggi de Il Disinformatico della Radiotelevisione Svizzera, scritto, montato e condotto dal sottoscritto: lo trovate qui sul sito della RSI (si apre in una finestra/scheda separata) e lo potete scaricare .

Le puntate del Disinformatico sono ascoltabili anche tramite iTunes, Google Podcasts, Spotify e feed RSS.

Buon ascolto, e se vi interessano il testo di accompagnamento e i link alle fonti di questa puntata, sono qui sotto.

---

[CLIP: Voce sintetica che legge tediosamente un avviso di cookie]

Se provate a cliccare su “Rifiuto" quando un sito vi chiede se accettate o rifiutate i cookie, due siti su tre in Europa ignoreranno la vostra richiesta. Quella irritantissima, onnipresente finestrella che da anni compare quando visitiamo un sito per la prima volta sembra essere insomma una totale perdita di tempo. Perlomeno questo è il risultato di un esperimento svolto recentemente da un gruppo di ricercatori del Politecnico federale di Zurigo su un campione di quasi centomila siti popolari europei.

Questa è la storia dei cookie, del perché esistono, del motivo per cui siamo assillati da queste richieste di accettarli o rifiutarli, e di questa ricerca che a quanto pare mina alla base la loro esistenza.

Benvenuti alla puntata del 19 aprile 2024 del Disinformatico, il podcast della Radiotelevisione Svizzera dedicato alle notizie e alle storie strane dell’informatica. Io sono Paolo Attivissimo.

[SIGLA di apertura]

Cookie, biscottini che vengono da lontanoCookie, che in inglese americano vuol dire letteramente “biscotto”, è un termine informatico che arriva dagli anni Ottanta del secolo scorso, quando lo si usava nei sistemi UNIX per indicare un pacchetto di dati ricevuto da un programma e restituito intatto al sistema informatico che glielo aveva mandato.

La stessa idea fu adottata anche per Internet e in particolare per il Web: nel 1994, ossia trent’anni fa, i cookie furono usati per la prima volta da uno dei primissimi browser, Netscape (ve lo ricordate?). Servivano per sapere se un utente aveva già visitato il sito di Netscape in precedenza. Il cookie era, ed è tuttora, semplicemente un file che viene scritto sul computer dell’utente dal sito visitato da quell’utente e contiene delle informazioni che quel sito può leggere in un secondo momento. Per esempio, se un utente fa una serie di acquisti su un sito, il contenuto del carrello della spesa virtuale può essere salvato in un cookie, così se cade la connessione l’utente non deve ricominciare tutto da capo.

All’epoca, trent’anni fa, l’esistenza dei cookie era sconosciuta alla maggior parte degli utenti. I cookie erano soltanto una soluzione tecnica, per addetti ai lavori: una delle tante che venivano sviluppate in quel periodo frenetico di evoluzione di Internet. Ma un articolo del Financial Times [This bug in your PC is a smart cookie, 12/2/1996] ne parlò ampliamente a febbraio del 1996, facendo notare le implicazioni di privacy dell’uso dei cookie e scatenando l’interesse dell’opinione pubblica.

Da quel debutto lontano i cookie hanno fatto molta strada, e sono diventati utilissimi per ricordare per esempio le preferenze di lingua o di aspetto di un sito, in modo da non doverle tediosamente reimpostare ogni volta che si visita quel sito, ma sono diventati anche una delle forme di tracciamento più usate su Internet per la profilazione commerciale degli utenti. Quelle implicazioni di privacy accennate tre decenni fa si sono avverate, insomma, e oggi i grandi operatori commerciali e le agenzie pubblicitarie usano i cookie per pedinare virtualmente gli utenti e osservare i loro interessi di navigazione. Oltre il 90% dei siti web traccia gli utenti e raccoglie dati personali.

Il rischio di abuso era troppo alto, e così nel corso degli anni sono state emesse varie direttive europee sulla privacy digitale che hanno fatto scuola anche in buona parte del resto del mondo. È il caso, per esempio, della direttiva ePrivacy del 2002 e in particolare del GDPR, entrato in vigore nel 2018. Ed è a quel punto che sono comparse in massa nei siti le finestre di richiesta di accettare o rifiutare i cookie.

Il GDPR, infatti, ha imposto ai siti di informare gli utenti del fatto che venivano tracciati e di come venivano tracciati tramite i cookie, e la finestra di richiesta (tecnicamente si chiama cookie notice) ha risolto quest’obbligo. Perlomeno dal punto di vista dei siti. Dal punto di vista degli utenti, invece, questa finestra incomprensibile, con i suoi discorsi su “cookie tecnici, cookie di funzionalità, cookie di profilazione e pubblicità mirata”, è stata percepita principalmente come una scocciatura, anche perché alla fine per poter usare i siti era quasi sempre necessario accettare questi benedetti cookie e quindi c’era ben poca scelta concreta.

E così siamo diventati un po’ tutti bravi cliccatori automatici del pulsante “Accetta tutti”, ma in sostanza non è cambiato nulla e continuiamo a essere profilati nelle nostre navigazioni.

Ricerca: il 65% dei siti web probabilmente ignora la richiesta di rifiuto dei cookieL’articolo dei ricercatori del Politecnico di Zurigo, disponibile presso Usenix.org, spiega il metodo usato per documentare con i dati quello che molti utenti sospettano da tempo: i ricercatori hanno adoperato il machine learning, una particolare branca dell’intelligenza artificiale, per automatizzare il processo di interazione con queste richieste di cookie dei siti. Questo ha permesso di estendere la ricerca a ben 97.000 siti fra i più popolari, scelti fra quelli che si rivolgono principalmente a utenti dell’Unione Europea, includendo siti scritti in ben undici lingue dell’Unione.

Con questo approccio, i ricercatori hanno potuto inoltre includere vari tipi differenti di avviso per i cookie e hanno potuto distinguere addirittura i vari tipi di cookie richiesti, ossia quelli necessari per il funzionamento del sito (i cosiddetti cookie tecnici) e quelli usati dai pubblicitari per tracciare i visitatori del sito (i cosiddetti cookie di profilazione), e sono riusciti anche a distinguere l’uso conforme o non conforme di questi cookie.

In pratica, il software sviluppato dai ricercatori ha interagito con gli avvisi per i cookie di questi siti nello stesso modo in cui lo avrebbe fatto una persona, ossia riconoscendone il testo e agendo di conseguenza, adattandosi alle singole situazioni, cliccando su “Accetto” o “Rifiuto” a seconda dei casi e acquisendo una copia dei cookie lasciati dal sito per verificare quali dati venivano acquisiti nonostante il rifiuto. Questo è il tipo di ricerca per il quale l’intelligenza artificiale risulta efficace e rende fattibili studi che prima sarebbero stati impossibili o assurdamente costosi.

I risultati, però, sono sconsolanti: oltre il 90% dei siti visitati con il software scritto dai ricercatori contiene almeno una violazione della privacy. Ci sono violazioni particolarmente vistose, come la mancanza totale di un avviso per i cookie nei siti che usano i cookie per la profilazione dei visitatori, che secondo i ricercatori si verifica in quasi un sito su tre, ossia il 32%.

Il 56,7% dei siti esaminati non ha un pulsante che consenta di rifiutare i cookie ma ha solo un pulsante per accettarli. I siti che hanno questo pulsante di rifiuto e fanno profilazione commerciale tramite cookie nonostante l’utente abbia rifiutato la profilazione sono il 65,4%. Fra i siti che usano i cookie di profilazione, uno su quattro, ossia il 26%, non dichiara di farlo.

Un altro dato interessante che emerge da questa ricerca è che i siti più popolari sono quelli che hanno la maggior probabilità di offrire un avviso per i cookie e un pulsante per rifiutarli e che maggiormente dichiarano di profilare gli utenti, ma sono anche i siti che tendono a ignorare maggiormente il rifiuto degli utenti o a presumere un consenso implicito. In altre parole, dicono i ricercatori, “i siti popolari mantengono una facciata di conformità, ma in realtà rastrellano più dati degli utenti di quanto facciano i siti meno popolari.”