Computer Quantistici ed equazioni non lineari

Quando ero bambino io, i microprocessori con registri a 8 bit, l’Intel 8080, ad esempio, o quelli con registri a 16 bit, mi pare l’Intel 8088, ma mi potrei sbagliare, l’età ormai è quella che è, non avevano abbastanza capacità computazionale per svolgere in tempi veloci i calcoli in virgola mobile.

Per chi non bazzica l’informatica la virgola mobile è una modalità, alquanto efficace, per approssimare i numeri reali. Il principio base è alquanto semplice. Consideriamo per esempio il numero 123.000. Se consideriamo le potenze di 10, potrebbe essere rappresentato 123 * 10^3, ossia tramite una coppia di valori: il fattore che viene moltiplicato alla potenza di 10, la mantissa, nel nostro caso 123 e l’esponente della potenza, pari 3.

Se nella vita normale sembrerebbe un’inutile complicazione, perchè usare due parametri invece di uno, nell’informatica semplica molto le cose. I numeri molto grandi o molto piccoli possono essere rappresentati suddividendo i bit a disposizione della variabile in tre: segno, esponente (di una base prestabilita, ovviamente una potenza di 2) e mantissa.

Come dicevo una quarantina d’anni fa, i microprocessori generici faticavano alquanto a eseguire i calcoli in questa modalità: per aggirare il problema, Intel e concorrenti, svilupparono un microprocessore dedicato proprio a questo compito, da affiancare, se necessario, a quello general purpose. Il primo che mi ricordo, se non erro, è l’Intel 8087.

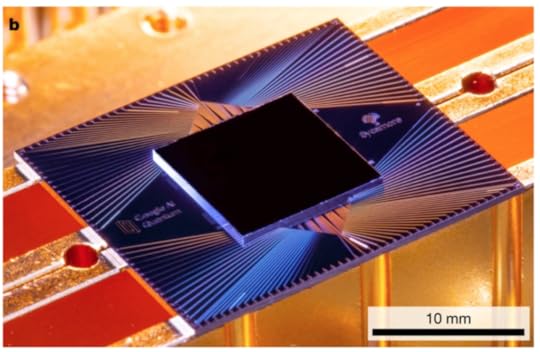

Questa soluzione mi pare durasse sino al 80486, che il Pentium non avesse un coprocessore matematico ne sono abbastanza sicuro: ora, per usare un’ardita metafora, i miei amati computer quantistici, allo stato attuale, svolgono di fatto la funzione di coprocessori matematici pompati a steroidi, smazzandosi quei calcoli degli algoritmi, che per un computer classico sarebbe troppo oneroso eseguire. Di fatto questa cooperazione pone una serie di problemi, legati, in soldoni, al far parlare una stessa lingua a mondi tra loro differenti. Come posso esprimere l’input in modo che possa essere comprensibile a un computer quantistico ? Come può interpretarne l’output un computer classico ?

Ora uno dei problemi a maggiore interesse che potrebbero essere macinati dai computer quantistici, di cui ho parlato le scorse settimane è nella risoluzione delle equazioni differenziali non lineari. Il punto di svolta, in tale campo, è arrivato nel 2010, quando Dominic Berry , ora alla Macquarie University di Sydney, ha costruito il primo algoritmo per risolvere le equazioni differenziali lineari in modo esponenzialmente più veloce sui computer quantistici, piuttosto che sui computer classici. Da quel momento in poi, si è scatenata una gara a chi potesse estendere tali risultati anche ai sistemi non lineari.

In questi giorni, stanno arrivando i primi risultati di tutti questi sforzi: Andrew Childs, dell’Università del Maryland, ed il gruppo di informatica quantistica del Massachusetts Institute of Technology, hanno infatti presentato due classi di algoritmi molto promettenti per la risoluzione di problemi non lineari utilizzando la tecnologia quantistica.

Il team di Childs ha, in soldoni, utilizzato la linearizzazione di Carleman, una tecnica matematica fuori moda risalente agli anni ’30, per trasformare i problemi non lineari in una serie di equazioni linea. L’uovo di Colombo? Purtroppo no, perchè questa serie è purtroppo infinita. Il problema è dove interromperla, a venti, trenta, cinquanta equazioni ?

Childs si è posto questo stesso problema: nell’articolo “A quantum algorithm for a class of nonlinear differential equations” ha identificato una classe di problemi la cui soluzione è approssimabile con un numero finito di equazioni, usando un algoritmo quantistico veloce ed efficiente.

Per identificarli, hanno definito L parametro, R, che rappresenta il rapporto tra la non linearità di un problema e il suo equivalente linearizzato: allo stato attuale, il valore di R è pari a 0,15.

Al MIT, invece, hanno utilizzato un approccio molto differente, degno di un romanzo di fantascienza, utilizzando il buon vecchio condensato di Bose Einstein. Questo è un particolare stato della materia in cui i bosoni sono raffreddati a una frazione di grado superiore allo zero assoluto, iniziando a comportarsi come un unicum anziché come particelle separate ed evidenziando comportamenti quantistici apprezzabili su scala macroscopica.

Teorizzato nel 1924 da Albert Einstein e Satyendranath Bose, fu osservato per la prima volta nel 1995 nel laboratorio NIST-JILA dell’Università del Colorado, da Wolfgang Ketterle, Eric Allin Cornell e Carl Wieman, che lo ottennero operando sul rubidio, raffreddato con una particolare tecnica al laser, cosa che fece vincere loro l’assai meritato Nobel. In questi anni, anche se non è una passeggiata di salute, di certo l’ottenere questo stato della materia è diventato assai più semplice.

In particolare nel 2011, il gruppo di lavoro del progetto NOMATOS (“Nonlinearity management of atomic and optical systems”) finanziato dall’Unione Europea e coordinato dall’università di Lisbona, utilizzò il condensato di Bose Einstein per studiare gli effetti non lineari nelle guide d’onda che, come suggerisce il nome stesso, “guidano” le informazioni sotto forma di onde elettromagnetiche tra due punti di una rete di telecomunicazioni. Per fare un esempio concreto, ricordando come la luce sia un’onda elettromagnetica, appartengono a questa categoria le fibre ottiche.

Gli effetti non lineari, non è proprio esatto, ma serve per rendere meglio l’idea, generano una sorta di interferenza, che diminuisce l’informazione trasferibile nel segnale e cresce con l’aumento della potenza emessa dalla sorgente: per cui, di fatto, pongono un limite alla distanza percorribile dall’onda, prima che perda, a causa dell’attenuazione e dei disturbi, qualsiasi utilità nel trasportare dati.

Meglio modellizziamo questi effetti, meglio possiamo progettare le guide d’onda: a parità di potenza possiamo fare percorrere alle onde distanze maggiori, oppure a parità di distanza, risparmiare potenza, con gli ovvi vantaggi economici.

Il team di NOMATOS utilizzò il Condensato di Bose Einstein per modellizzare un sistema di equazioni di Schrödinger non lineari, trovandone la soluzione. O perchè il burocrate di turno poco capiva delle implicazioni di tale scoperta o perchè gli scienziati non seppero spiegarsi bene, l’Unione Europea tagliò i fondi; i relativi articoli scientifici finirono dimenticati per qualche anno, finché non capitarono nelle mani degli scienziati del MIT, i quali ne generalizzarono i risultati. Sempre spiegando tutto in soldoni, utilizzano il Condensato di Bose Einstein per approssimare il problema non-lineare di partenza con un unico problema lineare.

Per cui, possiamo risolvere senza problemi le equazioni di Navier-Stokes o quelle di Black-Scholes ? Purtroppo non è così, per due motivi: il primo è che l’utilizzo di tali algoritmi per risolvere problemi pratici non lineari richiede computer quantistici con migliaia di qubit per ridurre al minimo l’errore e il rumore, cosa ad oggi tecnicamente non praticabile.

Il secondo è gli stati quantistici di output corrispondono a probabilità di eventi e non a valori assoluti. E’ immediato ottenere una media, ma molto più complicato analizzare i dati per ricostruire la soluzione completa del problema. Insomma, nonostante i progressi, c’è ancora tanto lavoro da fare.

Alessio Brugnoli's Blog